-

Compteur de contenus

2 344 -

Inscription

-

Dernière visite

-

Jours gagnés

173

Tout ce qui a été posté par brice.wernet

-

Jeu Le jeu du Screenshot

brice.wernet a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

Le rendu -> année 2000 environ -> à cette époque les jeux étaient encore souvent dédiés à un avion -> Cockpit russe + le petit truc en haut à droite -> Sukoï ou mig 29 (ça c'est d'expérience de ce genre de jeux) -> Page wiki "combat flight simulation videogame" -> deux trois vérifs -> site moby games en lien -> 1er screenshot 🙂 (ma seule hésitation: je trouvais le rendu plutôt classe pour 1997/98 - j'avais commencé par des jeux plus récents mais comme je "savais" que c'était un avion russe ...) -

Jeu Le jeu du Screenshot

brice.wernet a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

Mig 29 Fulcrum? -

Jeu Le jeu du Screenshot

brice.wernet a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

Bon, vu qu'il n'y a personne d'autre, je te l'accorde. @ceric64 - ce jeu est dispo sous Linux, dans les paquets standards de debian. -

Transformer un Rpi 3 en nano chaine-hifi

brice.wernet a répondu à un(e) sujet de Arcy dans Conseils d'achat

Dans ce cas la prise HDMI de la TV est condamnée, désolé j'avais mal compris, je pensais que la RPI3 pourrait servir à autre chose que le son. Je pensais plutôt à un boitier de ce genre (non ARC) Amazon Basics Convertisseur d'extracteur audio, HDMI vers HDMI + Audio (SPDIF + RCA stéréo), Noir : Amazon.fr: High-Tech Et je n'avais pas vu que le boitier proposé avant n'avait pas d'entrée HDMI (le ARC normalement c'est double sens, non?) -

Transformer un Rpi 3 en nano chaine-hifi

brice.wernet a répondu à un(e) sujet de Arcy dans Conseils d'achat

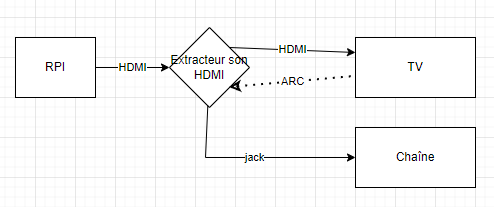

Voici le schéma en utilisant HDMI: dans ce cas: Dans tous les cas, ce qui est lu sur la RPI est reçu par la chaîne via l'extracteur de son Si la TV est compatible ARC (je ne suis pas convaincu) tout son de la TV ira sur la chaîne (c'est la flèche "retour" allant de la TV à l'extracteur -

Config petit home server (NAS, Docker, virtualisation)

brice.wernet a répondu à un(e) sujet de Cr0m4 dans Conseils d'achat

Source? En fait il faut que le trio (quatuor même) le supporte: CPU, chipset, BIOS, CG... Ensuite il faut que la configuration soit faite dans le BIOS, au niveau du boot de proxmox, et potentiellement dans la VM. Mais il existe de bons tuto pour les intel 12xxx: GitHub - Upinel/PVE-Intel-vGPU: This is a step-by-step guide to enable Gen 12/13 Intel vGPU using SR-IOV Technology so up to 7 Client VMs can enjoy hardware GPU decoding Là on n'est pas en passthrough pour une VM, mais carrément en partage de la CG sur plusieurs VM. Le disque est présent mais non monté dans proxmox, donc je peux l'attacher à une VM ou l'autre. C'est un SATA. C'est peut-être moins évident avec un NVMe Je fait du passthrough SATA/USB, parfois iGPU mais ma config est bateau et assez "vieille" (i5 9500T) mais c'est un ordi "pro". -

grésillement de mes rips CD en FLAC avec dBpoweramp...

brice.wernet a répondu à un(e) sujet de nightswan dans Audio, Vidéo, Photo et Créations

Tu as ripper à quelle vitesse? Si tu as l'occasion, mets le en USB. Prend un adaptateur USB/SATA et branche le en interne. Je ne rippe qu'en USB (pas de place en interne pour un lecteur) et je n'ai aucun problème. Je rippe en x4 la plupart du temps. -

Transformer un Rpi 3 en nano chaine-hifi

brice.wernet a répondu à un(e) sujet de Arcy dans Conseils d'achat

Il te faut un shield correct (hifi berry est pas mal du tout), avec les sorties qui vont bien (analogique et SPDIF/optique par exemple). Pour la vidéo toutefois, je conseillerais de rester avec un séparateur audio HDMI. Les "audiophiles" conseillent un shield avec un master clock, c'est surtout utile en liaison optique sur certains appareils en fait. Tu peux jeter un oeil sur des distro comme https://volumio.com/fr/ pour avoir une idée de ce qu'il faut en matériel. Ca pourrait. Les barres de son sont assez mauvaises en musique en général - pas du tout "tout terrain". Manque de présence et forte connotation "vidéo/plein la tronche". Tout dépend ce que tu écoutes et comment tu l'aimes. Là mon ampli est en panne, j'ai essayé sur la barre de son, c'est correct pour la pop, pour plein d'autres styles, c'est très très bof. Pour ton problème de voix dans l'audio de ta TV, essaie de demander à ta source (Kodi) d'envoyer en stéréo, pas le 5.1 ou le dolby surround ou le DTS. Ces formats ont un codage particulier et parfois la TV le gère très mal (certaines font carrément l'impasse sur les enceintes arrières! hors parfois elles contribuent aux voix) -

Jeu Le jeu du Screenshot

brice.wernet a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

-

Jeu Le jeu du Screenshot

brice.wernet a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

Space Hulk: Tactics? -

grésillement de mes rips CD en FLAC avec dBpoweramp...

brice.wernet a répondu à un(e) sujet de nightswan dans Audio, Vidéo, Photo et Créations

Même avec Windows media player (ou tout lecteur MS du moment)? Car si ça marche avec les outils Ms, tu pourras ripper avec Windows Media player classic. Par ailleurs, comment installes-tu AccurateRip et consors? Installation ou dézipage? Si dézippage, as-tu bien "débloqué" le fichier téléchargé? (j'ai eu la blague avec une certaine DLL et Handbrake, elle était encore marqué "bloqué" et il ne pouvait pas l'utiliser mais ne le disait pas. Tu as testé avec le câble de ton ancienne config? Peux-tu dans le panneau de configuration, sur le lecteur DVD, as-tu des options pour le mettre en mode silencieux ou gérer la vitesse maxi ou mieux: désactiver la correction d'erreur? Le fait que le même lecteur fonctionne différemment sur 2 machines fait penser que soit le pilote de base ne se comporte pas pareil, soit c'est la carte mère qui ne prend en charge automatiquement quelque chose (en l'occurence, la correction d'erreur). Les protections anti-copies des lecteurs CD sont prévues pour fonctionner quand on lit "trop vite" - lire en vitesse 1X (vitesse CD, la vitesse 1X DVD c'est CD x4 de mémoire) résout en général les problèmes. Mais pour piloter la vitesse, il faut que le logiciel en ait le droit, que la DLL (libcdread j'imagine) soit utilisable, que le lecteur l'accepte et que rien n'interfère entre le matériel et le soft. JE ne sais pas si de nouvelles couches peuvent interférer (pilotes RAID, hyperviseur, ...) Et même, ça ne marche plus depuis un service pack de XP. Il fallait que l'autorun le déclenche, et c'était du 32 bits, uniquement sur les CD audio avec une track cdrom en plus... -

grésillement de mes rips CD en FLAC avec dBpoweramp...

brice.wernet a répondu à un(e) sujet de nightswan dans Audio, Vidéo, Photo et Créations

Question, j'ai reparcouru le sujet et je n'ai pas vu la réponse: si tu lis simplement le CD, sans vouloir le ripper, tu as les glitches? Le résultat du AccurateRip me fait franchement penser que l'OS te pourri. Soit l'OS soit un pilote. Ca sent le DRM à plein nez. Que ce soit l'OS ou un truc importé avec un jeu vidéo. Je dois avoir le black album quelque part, j'essaierai de faire un test sur mes Windows 11. Tu utilises bien un CD acheté il y a longtemps dans un autre siècle? Perso je pense toujours qu'une lecture CD ne doit pas être perturbée autant (ou alors tu ne pourrais pas lire un disque dur)... D'où mon penchant pour le DRM. Si un lecteur externe fonctionne, tu peux toujours brancher ton lecteur interne en USB avec un adaptateur SATA-> USB et des prises usb internes 30cm/1FT 2 Port USB 2.0 A Female to Internal 9 Pin Header Adapter Cable .-lm | eBay Si par contre c'est un DRM, le lecteur externe risque de ne pas être une solution. Mais je n'ai pas eu de soucis ces dernières années, alors que je rippe encore un CD presque tous les mois. -

Bar Le Linux BAR - Discussion de tout et de rien

brice.wernet a répondu à un(e) sujet de Dark26 dans GNU/Linux, *BSD et dérivés d'UNIX

Est-ce que tu peux te connecter en ssh sur la mac mini depuis un autre ordi? Mais c'est un des gros problèmes de linux en desktop: la reprise de mise en veille, le multi moniteur et la connexion à chaud des moniteurs. C'est souvent un motif de redémarrage (souvent en aveugle) quelque soit la distro (sur ce que j'ai vu récemment: pop, Ubuntu, debian, arch...) -

Jeu Le jeu du Screenshot

brice.wernet a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

Sans conviction: galactic junk league? -

Config petit home server (NAS, Docker, virtualisation)

brice.wernet a répondu à un(e) sujet de Cr0m4 dans Conseils d'achat

La conclusion c'est que mon expérience AMD pour la virtu sous Linux a été catastrophique avec 3 essais. Jamais eu de problème sous Intel. Donc oui, Intel. Les 8Go: ZFS est connu pour avoir besoin de RAM, dédup ou pas. C'est un FS serveur, il est puissant et performant, mais il est gourmand en RAM. -

Config petit home server (NAS, Docker, virtualisation)

brice.wernet a répondu à un(e) sujet de Cr0m4 dans Conseils d'achat

Mon disque de stockage NAS est dédié OMV par un pass-through. Il est donc "débranchable" et connectable tel que pour l monter dans une autre machine. C'est d'ailleurs LA raison pour laquelle je suis resté sur Intel: mes essais de passthrough avec AMD et une plate-forme grand-public ont tous complètement capoté ou étaient instables (sous proxmox, depuis j'ai fait un test avec xen qui fonctionne). En AMD, pour le passthrough, il faut la bonne combinaison CPU+chipset+bios. Et si CPU et chipset on peut trouver ce qui est faisable, si le BIOS ne suit pas (exemple: Asrock X300 mini il y a 2 ans...), c'est impossible. Les passthrough que j'ai testés (2 ans déjà): La CG: échec systématique sur AMD avec la CG intégrée - ok avec intel, mais bon, ça ne sert à rien avec un HD620 🙂. L'USB: ça a marché partout en USB2, mais stable en USB3 que sur Intel (cartes réseau, disques USB, zigbee, ports complets ...) PCIe pour disque NVMe: AMD que des expériences instables SATA: AMD - rares instabilités, intel: ça tourne depuis plus de 2 ans (c'était actif avant mon changement de plate-forme) -

Problème de connexion avec Vmware

brice.wernet a répondu à un(e) sujet de Scorpio dans Réseaux, Internet, Téléphonie et Services en Ligne

De mémoire car j'étais dev et donc pas totalement dans le sujet à l'époque: les hubs avaient été achetés (sans concertation) et installés par la hotline pour répondre à des demandes d'installation d'ordi et d'imprimantes sans passer par les admins infra. Mais au moment de mettre en place des VLAN et du 802.1X, ces hubs non manageables étaient un problème. Et je pense que le responsable des admins avait envie de montrer qui était le patron sur le réseau. -

Problème de connexion avec Vmware

brice.wernet a répondu à un(e) sujet de Scorpio dans Réseaux, Internet, Téléphonie et Services en Ligne

Il y a 15 ans, ce type de paramètre avait été utilisé pour faire la chasse au hubs. Le résultat avait été le même pour les postes de dev avec une VM: plus de bridge possible. C'est un paramètre qui fait que les demandes DHCP sont "marquées" avec l'adresse physique branchée et envoyée à l'adresse IP qui a déjà été fournie. La 1ère affectation DHCP fonctionne, la seconde est reçue par la première adresse IP qui en général ne la redistribue pas puisqu'elle est le endpoint. Bref, ce type d'option assure que pour chaque prise, une MAC = une IP -

Config petit home server (NAS, Docker, virtualisation)

brice.wernet a répondu à un(e) sujet de Cr0m4 dans Conseils d'achat

En tout cas, ne te mine pas pour le CPU. Moi j'ai ceci: Dell OptiPlex 3070 - Micro - Core i5 9500T / 2.2 GHz - RAM 8 Go - SSD 128 Go - UHD Graphics 630 - GigE - LAN sans fil: 802.11a/b/g/n/ac, Bluetooth 4.1 - Win 10 Pro 64 bits - moniteur : aucun - noir - BTS - avec 1 an basique sur site - Unités Centrales - Achat & prix | fnac (250€ d'occas il y a 3 ans). Le 9500T est en 6C/6T. J'ai proxmox dessus avec: 2x minecraft PE Opn sense Open Media Vault Homeassistant 1 nextcloud 1 VM pour compiler des projets assez gros (ROM android notamment) D'autres VM de test qui traînent (jitsi) Par rapport à tes besoins, c'est limité surtout pour le SATA (je n'ai que 2 disques en interne + 1 en USB) et c'est de la SODIMM. Franchement, je te conseille de taper par exemple sur de l'ordi de bureau "pro" genre prodesk 600 ou 605 -

Projet via récup

brice.wernet a répondu à un(e) sujet de MeowMeow dans GNU/Linux, *BSD et dérivés d'UNIX

Mon 1er rpi, reçu day-0, a servi de proxy filtrant/dans menteur/ point d'accès wifi pour les enfants (purée c'est loin...) - mais pas bien longtemps car il ne tenait pas le coup niveau alim et rebootait tout le temps. Je suis vite passé au nuc celeron: la même charge faisait 100% sur le pi, 10% sur le celeron. Là j'ai trois trucs à faire avec des pi: remplacer le lecteur audio du salon, faire un lecteur triple cd (un ESP pourrait suffire mais pas le temps) et un émulateur mt-32. Ah oui, et un atariche (mettre un pi dans un atari st en conservant le clavier et le lecteur de disquettes) Je dois avoir encore 4-5 pi 2 et 3 dans les tiroirs,+ une 4 qui n'a jamais servi. J'en avais acheté une dizaine de chaque sur eBay une fois (140€ à chaque fois, remboursées en en revendant à l'unité) -

Projet via récup

brice.wernet a répondu à un(e) sujet de MeowMeow dans GNU/Linux, *BSD et dérivés d'UNIX

Je préfère souvent les nuc: 4,5-9W à vide selon modèle mais 1gb/s et possibilité d'en faire infiniment plus sur une seul machine. J'ai vu aussi que les mini pc Intel en 12xxx arrivent à moins de 7W à vide avec 32go de ram. -

Débits SSD chutent après partionnement

brice.wernet a répondu à un(e) sujet de Depy1501 dans Microsoft Windows (Mobile)

De quel partitionnement parles-tu? Normalement le partitionnement d'un disque ne change rien à ses performances brutes. As-tu branché le disque toujours de la même façon? Avant de lancer le test, le disque étzit-il bien au repos? La chaleur est effectivement une bonne piste dans un portable. Un échauffement d'un autre composant proche peut faire que le SSD se limite, ainsi que le mode de performances. -

Projet via récup

brice.wernet a répondu à un(e) sujet de MeowMeow dans GNU/Linux, *BSD et dérivés d'UNIX

Pi hole, home assistant, openwrt, les 3 en même temps via la virtuosité tu le veux. Ou serveur audio si comme les nuc il a l'infrarouge et le spdif. Serveur Minecraft aussi. Ou rétrogaming. Avec micro intégré, ça peux faire serveur Sarah (un vieux projet pour faire un assistant personnel de maison à la Jarvis) -

Différence entre la ver Software 9.00 et 11.00 PS4 ?

brice.wernet a répondu à un(e) sujet de moutezz dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

La version de quoi??? 9 et 11, c'est des versions du TOS??? -

la mémoire ne peut pas être written avec Virtualbox sous Win11

brice.wernet a répondu à un(e) sujet de fafief dans Ordinateurs de bureau et Composants

J'ai relu un peu, ce bug semble vieux... Ça semble plutôt être côté graphique que ça se résout souvent, sinon côté réseau. Comment connectes-tu ta VM au réseau? Pour les pilotes graphiques, basculer simplement sur les pilotes ms devrait suffir (j'ai testé sur ma NVIDIA, je peux basculer d'un pilote à l'autre sans voir de problèmes) Pour les coeurs/threads, je ne sais pas comment vbox compte. Essaie quand même de les baisser à 8 voire 4vcpu. Et sinon, cherche du côté de ta CM. Les problèmes insolubles de virtuel, je n'en ai eu que sur des plateformes ryzen. En cause d'après moi: la partie virtualisation pas intégrée correctement dans les bios grand public et la complexité chez AMD: il faut que tout concorde: CPU, chips et et BIOS, sinon ... Hyper-v par contre a de bons résultats. Et il se pilote en ligne de commande ou interface Tu peux l'activer dans ton windows ou télécharger windows serveur pour hyper v, c'est gratuit.