Toute l’activité

- Dernière heure

-

Jeu Le jeu du screenshot cinématographique

MeowMeow a répondu à un(e) sujet de beholder2 dans Espace Détente

- Aujourd’hui

-

Où acheter un Office légal au meilleur prix

digital-jedi a répondu à un(e) sujet de digital-jedi dans Microsoft Windows (Mobile)

Hummm, pour l'instant, j'en suis à 3 clés achetées sur Kinguin en 2021 et 2022 sans souci. Et au final, je découvre que le vendeur initial était NextKeys.io Reviews | Read Customer Service Reviews of nextkeys.io (trustpilot.com) Cela dit, le lien CanardPC partagé plus haut récapitule bien les problèmes potentiels effectivement sur ce marché gris. -

Où acheter un Office légal au meilleur prix

digital-jedi a répondu à un(e) sujet de digital-jedi dans Microsoft Windows (Mobile)

Effectivement, je découvre : Microsoft office home & student 2019 complète 1 licence(s) français - La Poste à 35€ > qui amène vers : Microsoft Office 2019 Famille et Etudiant à télécharger (destock-informatique.com) à 30€ Partenaire Microsoft | Destock Informatique (destock-informatique.com) "Hormis les licences de type OEM, FPP, Retail, VL (MAK, KMS) que nous proposons, nous pouvons également faire bénéficier nos clients d’autres options de licences commerciales..." -

Où acheter un Office légal au meilleur prix

MeowMeow a répondu à un(e) sujet de digital-jedi dans Microsoft Windows (Mobile)

-

Merci pour ces infos ^^ Chimera c'est du archlinux, c'est vraiment épuré. J'aime bien archlinux.

-

J'ai un avis plus nuancé: c'est variable. Les jeux Source: excellents sous Linux. Sur l'APU, je peux même pousser en 4K en baissant la qualité (sans intérêt, le FHD rend mieux) Code masters: Excellents - Dirt sur l'APU Vega 11 est au niveau de Dirt sur la bécane de jeux sur une GTX1050 (je veux dire que je peux le passer en 60FPS antialiasing + synchro verticale - je pense qu'effectivement la GTX peut faire plus de FPS, mais je joue sur des TV, donc je suis limité à 60Hz environ) Gearbox: cela dépend: les portages sous-traités (comme Borderlands 2): excellent, MAIS la sauvegarde n'est pas compatible avec la version Windows Tiny tina (natif gearbox): perfs générales en baisse et quelques plantages au démarrage pendant le calcul des shaders. Et d'une façon générale (et en plus ma machine Linux est mon ancienne machine Windows): temps de chargements supérieurs sous Linux (mais pas sous chimera os: c'est une debian desktop tout ce qu'il y a de plus classique). Par contre, niveau réseau: j'ai eu du mal à atteindre les 250/300mb/s en download sur le wifi sous Windows, sous Linux je suis à 480-500 (au même endroit) sans rien bidouiller.

-

Après tu peux faire un mini pc qui deviendra une console de jv avec Chimera OS -- >https://chimeraos.org/ (prendre un proc ryzen). Vidéo présentation ici . Tu fais ton pc avec ce type de tour : ici et jouer via : Steamlink. Les jeux qui tourne sous linux ont une meilleure perf que les jeux sous windows.

-

Euh, du coup, je trouve le PC bien trop puissant. Quand tu dis jouer via Steamlink, ce PC est l'émetteur sur lequel le jeu tourne ou le récepteur? Perso j'ai cela sous ma TV (enfin, j'ai la 1ère version, en Ryzen 3400GE). https://www.lenovo.com/fr/fr/configurator/cto/index.html?bundleId=11JNCTO1WWFR2 (tu peux encore baisser le prix en enlever RAM et SSD si tu les as Tiny Tina tourne avec quelques concessions en FHD sous Linux à plus de 30lFPS. Portal il est rock solid à 60FPS ... sur cet APU de 2020. -> Un mini PC avec un APU RDNA2 ne suffirait-il pas? Sinon, tu peux te trouver un truc de ce genre en occas: https://www.lenovo.com/fr/fr/p/desktops/thinkcentre/m-series-sff/thinkcentre-m75s-gen-2/11tc1mdm75s + un RTX A2000 d'occas (c'est une GTX 3050 "pro" en format 1/2 hauteur et sans alim externe) -> Ca fait un config plutôt sympa, qui ne chauffe pas trop, et passe dans les meubles TV.

- Hier

-

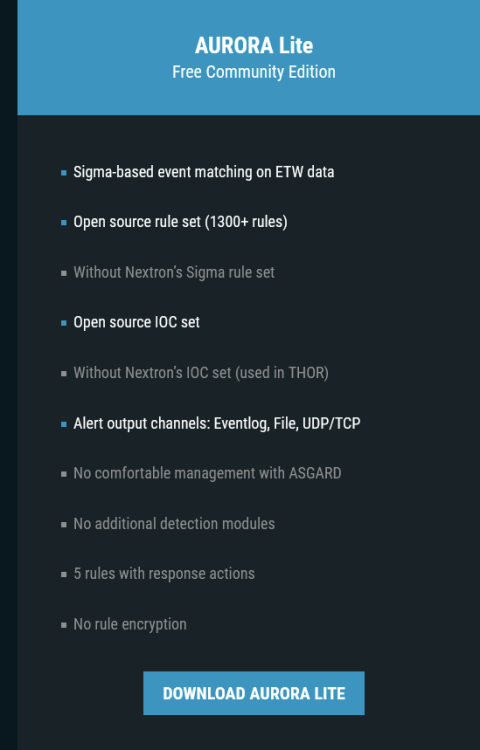

EDR Aurora lite avec des règles open source.

MeowMeow a répondu à un(e) sujet de MeowMeow dans Microsoft Windows (Mobile)

Tout se passe sur observateur d'évènement de windows. La partie console, c'est dans la partie full (donc payante). -

Je suis du même avis que toi. Il existe des mini tours (cela me rappel l'époque des lans avec les shuttles).

-

EDR Aurora lite avec des règles open source.

ashlol a répondu à un(e) sujet de MeowMeow dans Microsoft Windows (Mobile)

de mémoire il me semble qu'il avait dit que t'avais aussi une console d'admin même en lite, il fallait se connecter sur une ip locale ou un truc du genre. -

EDR Aurora lite avec des règles open source.

MeowMeow a répondu à un(e) sujet de MeowMeow dans Microsoft Windows (Mobile)

Dac 🙂 Je l'ai mis sur mon pc perso. Mais c'est vrai que tu n'as de console en lite. Et je n'ai pas trouvé de tuto pour vraiment bien exploité les règles en mode lite. -

Où acheter un Office légal au meilleur prix

refuznik a répondu à un(e) sujet de digital-jedi dans Microsoft Windows (Mobile)

Autant prendre une clef à 10 euros max. - La dernière semaine

-

Où acheter un Office légal au meilleur prix

Aloyse57 a répondu à un(e) sujet de digital-jedi dans Microsoft Windows (Mobile)

Ayant été un acheteur de ces clés, je suis revenu sur mes décisions. Ces clés sont gérés par quelqu'un de l'extérieur avec un compte que vous ne maitrisez pas. Il peut revendre la clé plusieurs fois et un beau jour la votre ne fonctionne plus. Ou accéder à vos données selon le type de compte. Le seule et unique moyen d'avoir une clé sûre et de l'acheter sur le site de Microsoft et de payer une blinde. Maintenant, si c'est pour un usage limité dans le temps (par exemple pour un PC que vous allez garder 3 ans), c'est bon. Au pire vous en rachèterez une, 2 ou trois fois. -

Où acheter un Office légal au meilleur prix

digital-jedi a répondu à un(e) sujet de digital-jedi dans Microsoft Windows (Mobile)

Bonjour, Je reviens sur le sujet ! Comment savoir si cette clé de logiciel MS Office 2021, vendue 111€ officiellement sur Amazon par Microsoft, est une Retail Key ? Ou est-ce forcément une Retail Key puisqu'elle est vendue dissocié de tout HW et par Microsoft ? Microsoft Office Famille et Étudiant 2021 | Achat définitif | 1 PC ou MAC | Téléchargement : Amazon.fr: Logiciels C'est pour un ami de connaissance qui est prêt à débourser ce prix là, mais qui veut une licence "à vie". Je ne veux juste pas qu'il se fasse empapaouter sur ce détail Retail. Parce qu'il existe apparemment des "ISO key" : https://www.kinguin.net/fr/category/230076/ms-office-2021-professional-plus-iso-key "This key can be used only one per PC/motherboard." Mais ca se trouve, c'est de l'anglais mal écrit, qui veut juste dire qu'il faut (le désinstaller du précédent PC et) juste refaire la procédure d'activation via Microsoft sur un nouveau PC. Sans sous-entendre que la clé de licence sera attachée/verrouillée au 1er HW sur lequel elle est installée. -

EDR Aurora lite avec des règles open source.

ashlol a répondu à un(e) sujet de MeowMeow dans Microsoft Windows (Mobile)

La chaine Underscore_ (Micode) en a fait une chronique récemment et il le trouvait globalement bien. La vidéo viens d'être retiré car pas assez quali et il y avait de mauvaise explication dedans d'après les commentaires youtube mais cela n'enlève pas le fait que en perso ou pour quelques pc en réseau il est très puissant. c'est un edr donc en fonction des règles que tu mets cela peut être vraiment très pointu et très léger sur les machines des users. -

EDR Aurora lite avec des règles open source.

MeowMeow a posté un sujet dans Microsoft Windows (Mobile)

Bonjour, Je viens de découvrir ce produit : ici C'est un produit gratuit avec licence d'1an . Avec des règles d'open source. J'aimerais savoir si des personnes du forum, l'utilisent en perso ou autres? -

Jeu Le jeu du screenshot cinématographique

MeowMeow a répondu à un(e) sujet de beholder2 dans Espace Détente

-

Centralisation Problèmes sur le forum de Next INpact

Edtech a répondu à un(e) sujet de P-A dans Vie INpactienne

Non, ça c'est en l'hébergeant soi-même. Après tu as une version dans le Cloud (et c'est beaucoup plus cher, à partir de 1 068$/an) : Sign up for Invision Community - Invision Community -

Centralisation Problèmes sur le forum de Next INpact

Aloyse57 a répondu à un(e) sujet de P-A dans Vie INpactienne

Bonjour, Je ne connais pas le produit Invision : je ne sais pas si c'est une solution tout-en-un ou juste un outil thématique. A part les $499 de frais initiaux pour obtenir une licence, est-ce qu'il faut ajouter l'hébergement (chez eux ou ailleurs) ou tout est compris dans le $199 annuel ensuite ? -

Centralisation Problèmes sur le forum de Next INpact

Edtech a répondu à un(e) sujet de P-A dans Vie INpactienne

J'ai déjà contacté Invision, ils ne peuvent pas transférer une licence. Oui, certains ont encore des contacts avec Teuf, mais je n'ai pas eu de retour sur ce compte perdu. -

Centralisation Problèmes sur le forum de Next INpact

ashlol a répondu à un(e) sujet de P-A dans Vie INpactienne

j'imagine que vous avez contacté Teuf pour récupérer son compte et qu'il n'a pas répondu ou ne s'en rappelle plus c'est ça ? ça m'étonnerait qu'aucun journaliste n'ait pas un email perso de Teuf ou même son téléphone. Sinon il doit y avoir moyen de discuter avec invision pour dire que le site à été racheté et qu'il faudrait changer l'email et mdp de se compte. -

Centralisation Problèmes sur le forum de Next INpact

refuznik a répondu à un(e) sujet de P-A dans Vie INpactienne

Ouch ! -

Centralisation Problèmes sur le forum de Next INpact

Edtech a répondu à un(e) sujet de P-A dans Vie INpactienne

Invision a changé sa façon de faire, avant, c'était flexible : 40$/6 mois pour le site de base. Et on payait en plus 30$ il me semble pour la galerie, soit 140$/an (la première année, on payait 200$) Maintenant, c'est 199$/an avec tous les modules (même celui de commerce). On a ensuite un problème : personne n'a le compte qui possédait la licence (celui de Teuf), donc on ne peut pas renouveler et passer aux 199$ par an. On doit repartir de zéro et donc c'est 499$ la première année, puis on revient aux 199$/an. Invision Community Classic - Invision Community -

Format de sortie audio bloqué (Win11)

brice.wernet a répondu à un(e) sujet de Depy1501 dans Microsoft Windows (Mobile)

Non, surtout que tu ne peux pas monter plus haut que le réglage par défaut du pilote 2022... Donc avec le pilote Windows tu peux "baisser la qualité". Si tu l'entends, comme le dit @ashlol Je conseille quand même en général de laisser les pilotes Windows. Les constructeurs suivent peu les pilotes pour leurs ordis, et les bourrent de softs inutiles, aux fonctionnalités douteuses ou mal finies. Bref, pas de pilote constructeur par défaut.