Toute l’activité

- Hier

-

Jeu Le jeu du Screenshot

ElMarcassin a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

-

Jeu Le jeu du Screenshot

refuznik a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

Yep. -

.thumb.jpg.2511afb400b1d0c77b01a031d7163d57.jpg)

Clé USB - Deux messages d'erreurs lors du transfert

Depy1501 a répondu à un(e) sujet de Depy1501 dans Mobilité et périphériques portables

J'ai nettoyé l'intérieur avec une soufflette, il y avait un peu de poussière mais ça n'a rien changé. Le souci est le même en USB2. J'y ai cru pourtant 😛 -

Problème d'encodage lors d'une migration MARIADB

Bamaury a répondu à un(e) sujet de Bamaury dans Programmation et Lignes de code

abandon temporaire de mon côté. J'ai installé une mariadb 10.1.48 au lieu d'une 10.3 , ça résoud instantément mes soucis d'encodage. Le responsable sécurité m'a dit que dans un premier temps ça ira. Ensuite je verrai comment je peux mettre à jour l'image docker sans souci. Merci pour l'aide -

Jeu Le jeu du Screenshot

ElMarcassin a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

Bon, ça fait 24h, je reposte : SlavicPunk : Oldtimer -

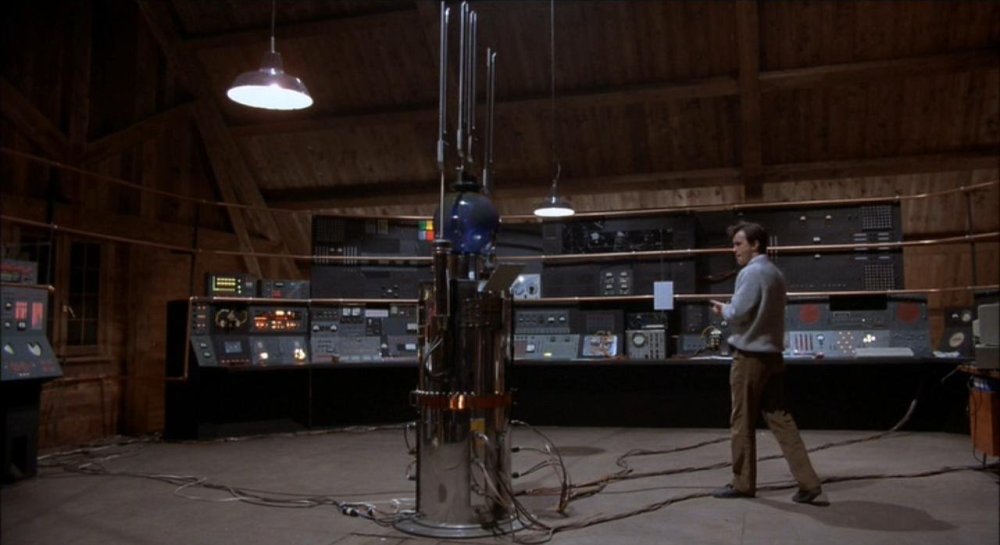

Jeu Le jeu du screenshot cinématographique

MeowMeow a répondu à un(e) sujet de beholder2 dans Espace Détente

-

Jeu Le jeu du screenshot cinématographique

Chromosome3 a répondu à un(e) sujet de beholder2 dans Espace Détente

Bingo !! Je commençais à douter, j'ai failli mettre une capture avec Jeffrey Combs -

Jeu Le jeu du screenshot cinématographique

MeowMeow a répondu à un(e) sujet de beholder2 dans Espace Détente

From beyond – Les portes de l’au-delà - La dernière semaine

-

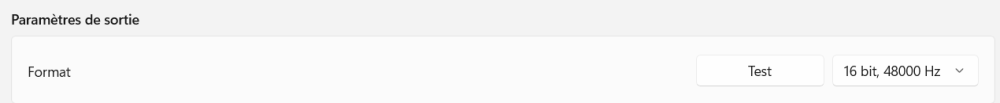

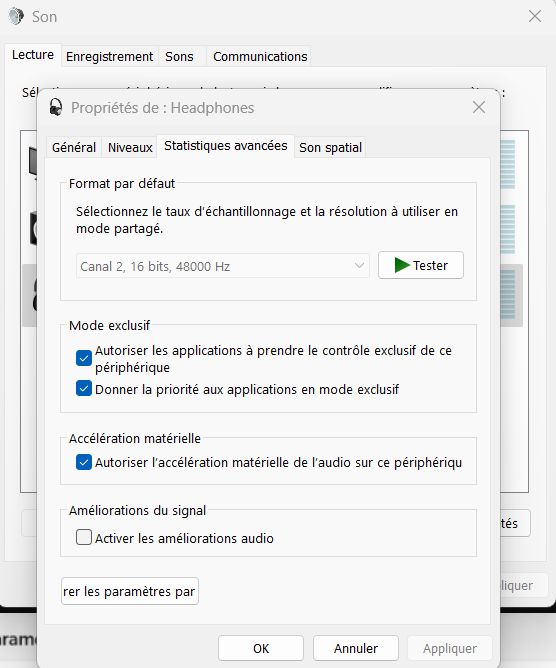

Format de sortie audio bloqué (Win11)

brice.wernet a répondu à un(e) sujet de Depy1501 dans Microsoft Windows (Mobile)

Quel format attendais-tu/voulais-tu mettre? Quelle est la référence de la "carte" son (ou du portable)? Sur quoi sort le son? (si c'est en HDMI ou en optique, ça peut être limité en format par le récepteur) [Édit] Tu sors sur un équipement BT peut-être ? Ça serait une excellente explication -

Format de sortie audio bloqué (Win11)

ashlol a répondu à un(e) sujet de Depy1501 dans Microsoft Windows (Mobile)

soit tu as une application en mode exclusif qui utilise cette sortie son (l'application netflix utilise en général le son en mode exclusif pour bypasser les paramètres windows par exemple) ou alors ce PC n'a que ce format de dispo ce qui est courant sur les pc portables -

Depy1501 a commencé à suivre Format de sortie audio bloqué (Win11)

-

Bonjour à tous, Ayant acquis récemment un pc portable sous Win11, je constate que le format du paramètre de sortie son est bloqué en 16 bits/48Khz. Dans la liste, aucun autre paramètre n'est visible. Sur Win 7 et 10 sur d'autres pc, il était possible de modifier ce paramètre... Avez-vous une idée? J'ai regardé de deux manières différentes pour la sortie casque et hauts parleurs : Via paramètre, système, son, propriétés. Là, la liste déroulante n'a qu'une seule possibilité en 16/48. En ouvrant la fenêtre classique via "mmsys.cpl". Là, le choix du format est grisé, pas possible de voir s'il existe d'autres formats. Windows et les pilotes sont mis à jours, Windows update ne me propose rien dans les téléchargements. Realtek semble mis à jour via Microsoft Store et j'ai le même choix d'options. J'avoue que je débute sous Windows 11 donc il y a peut être des subtilités que je n'ai pas! Merci 🙂

-

Jeu Le jeu du Screenshot

ElMarcassin a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

The ascent ? -

Jeu Le jeu du Screenshot

refuznik a répondu à un(e) sujet de superlapin62 dans Jeux vidéo, Consoles, Rétrogaming et Jeux occasionels

-

Performances Furmark 2 - Radeon RX 5600M

bred94 a répondu à un(e) sujet de bred94 dans Ordinateurs portables

Merci Ashlol, effectivement RAS le pc fonctionne comme il faut 🙂 -

Team World community grid Team Next-INpact

percubabs a répondu à un(e) sujet de percubabs dans Débats et Discussions

salut à tous, Je vois que ça plie toujours, c'est bien. Je vais regarder pour ajouter une machine si je retrouve mes comptes. à plus -

Jeu Le jeu du screenshot cinématographique

Chromosome3 a répondu à un(e) sujet de beholder2 dans Espace Détente

-

Performances Furmark 2 - Radeon RX 5600M

ashlol a répondu à un(e) sujet de bred94 dans Ordinateurs portables

c'est tout à fait normal -

Performances Furmark 2 - Radeon RX 5600M

bred94 a répondu à un(e) sujet de bred94 dans Ordinateurs portables

A propos du test sur unigine heaven je suis dessus cependant les réglages précis utilisés dans le test de notebookcheck me sont inconnus. Les préréglages possibles sont les suivants : custom, basic et extreme, pour régler la qualité en "high" c'est dans custom mais après il y a d'autres réglages à déterminer^^ En tout cas j'obtiens le résultat suivant sur mon pc - preset extreme (1600*900) : 88FPS Voilou -

Bar -=# Le NETwork Bar #=-

ceric64 a répondu à un(e) sujet de Squall NTCK dans Réseaux, Internet, Téléphonie et Services en Ligne

Bonjour, Je me réponds à moi-même. J'ai résolu le problème en cochant "voulez-vous enregistrer ce mot de passe dans le trousseaux" (ou quelque chose comme ça). -

Jeu Le jeu du screenshot cinématographique

Chromosome3 a répondu à un(e) sujet de beholder2 dans Espace Détente

-

Problème d'encodage lors d'une migration MARIADB

Bamaury a répondu à un(e) sujet de Bamaury dans Programmation et Lignes de code

merci, j'ai pas le temps d'essayer aujourd'hui mais je tiens au courant - Avant

-

Mode rescue

brice.wernet a répondu à un(e) sujet de brice.wernet dans GNU/Linux, *BSD et dérivés d'UNIX

Pas de RAID, et de toutes façons ça ne semblait pas une panne de HDD. J'ai pu faire un scp pour récupérer la BDD et les fichiers en mode rescue. -

même les kimsufi sont tous en raid1 donc logiquement ton serveur devrait être remis sur pieds sans douleur après l'inter Si c'est une panne de HDD

-

Jeu Le jeu du screenshot cinématographique

Chromosome3 a répondu à un(e) sujet de beholder2 dans Espace Détente

-

Mode rescue

brice.wernet a répondu à un(e) sujet de brice.wernet dans GNU/Linux, *BSD et dérivés d'UNIX

J'ai essayé plusieurs trucs, au final j'ai lancé une réinstall depuis l'interface ... qui a raté... ils interviennent. Entre-temps, j'ai fait un backup en ssh depuis le mode rescue - et je l'ai passé sur une VM: il boote. Donc pb physique ou pb grub + mode de démarrage de la machine.